DeepSeek开源第二弹:首个用于MoE模型训练的通信库DeepEP

三言科技消息 DeepSeek正式启动“开源周”,首个开源的代码库为FlashMLA。据悉,DeepSeek本次“开源周”将陆续开源5个代码库。

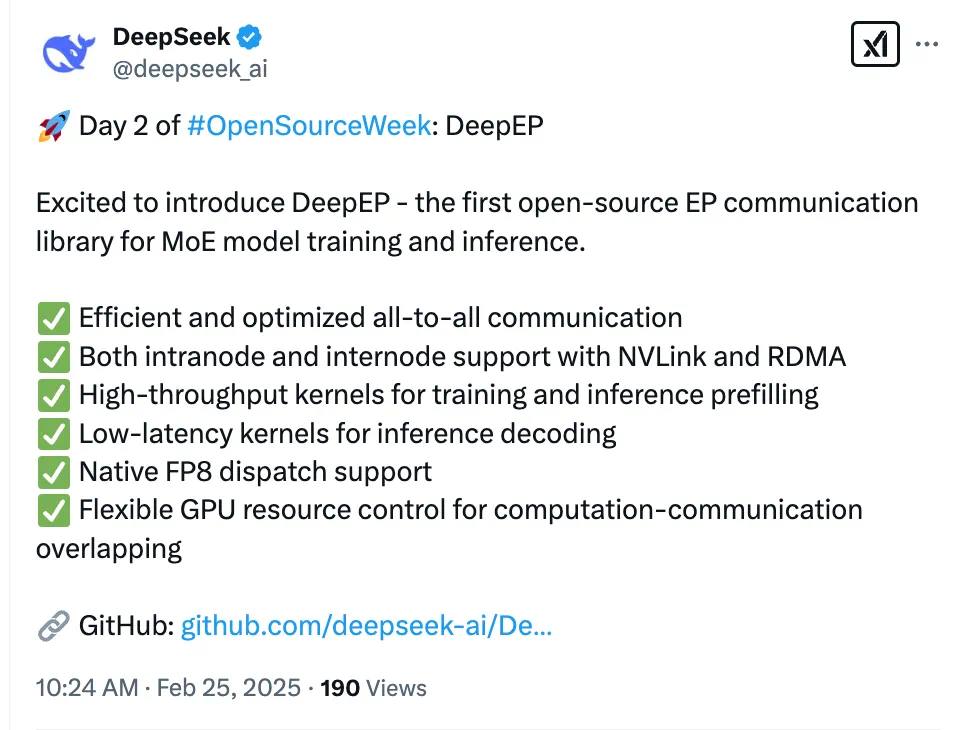

今天,DeepSeek官方推出开源第二弹:首个用于MoE模型训练和推理的EP通信库DeepEP。

DeepEP可以做到:

1. 高效优化的 All-to-All 通信

2. 支持 NVLink 和 RDMA 的节点内 / 跨节点通信

3. 训练及推理预填充阶段的高吞吐量计算核心

4. 推理解码阶段的低延迟计算核心

5. 原生支持 FP8 数据分发

6. 灵活控制 GPU 资源,实现计算与通信的高效重叠

名词解释:

MOE:全称Mixture of Experts,也就是混合专家模型。是一种通过使用多个不同的子模型(或“专家”)来提升 LLM 质量的技术。

EP:专家并行(Expert Parallelism)。将 MoE 中的不同专家分配到不同的计算设备上。