DeepSeek R1 模型已完成小版本升级,当前版本为 DeepSeek-R1-0528。用户通过官方网站、APP 或小程序进入对话界面后,开启“深度思考”功能即可体验最新版本。API 也已同步更新,调用方式不变。

今日官方发文对更新进行详细说明。

深度思考能力强化

DeepSeek-R1-0528 仍然使用 2024 年 12 月所发布的 DeepSeek V3 Base 模型作为基座,但在后训练过程中投入了更多算力,显著提升了模型的思维深度与推理能力。

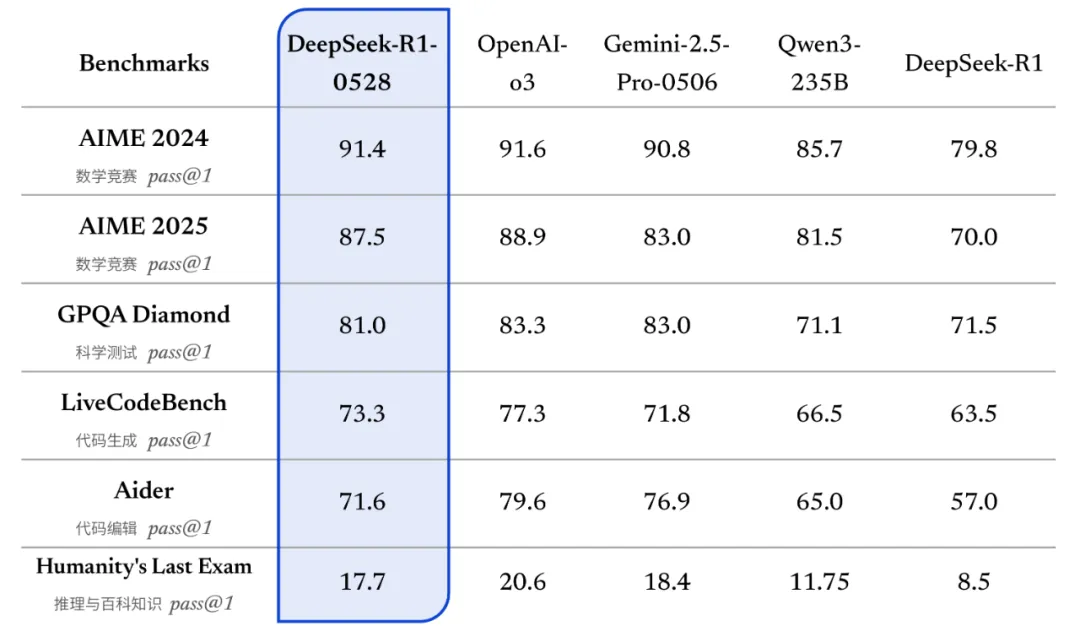

更新后的 R1 模型在数学、编程与通用逻辑等多个基准测评中取得了当前国内所有模型中首屈一指的优异成绩,并且在整体表现上已接近其他国际顶尖模型,如 o3 与 Gemini-2.5-Pro。

DeepSeek-R1-0528 在各项评测集上均取得了优异表现

(基准测试使用 64K 输出长度;在 Humanity's Last Exam 中,只使用其中的文本题目进行测试)

相较于旧版 R1,新版模型在复杂推理任务中的表现有了显著提升。例如在 AIME 2025 测试中,新版模型准确率由旧版的 70% 提升至 87.5%。这一进步得益于模型在推理过程中的思维深度增强:在 AIME 2025 测试集上,旧版模型平均每题使用 12K tokens,而新版模型平均每题使用 23K tokens,表明其在解题过程中进行了更为详尽和深入的思考。

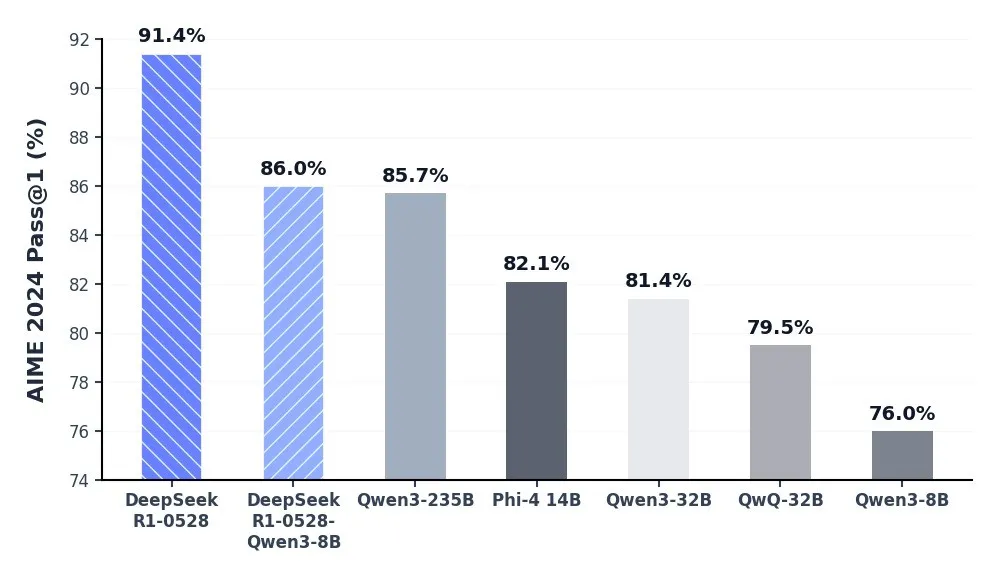

同时,我们蒸馏 DeepSeek-R1-0528 的思维链后训练 Qwen3-8B Base,得到了 DeepSeek-R1-0528-Qwen3-8B。该 8B 模型在数学测试 AIME 2024 中仅次于 DeepSeek-R1-0528,超越 Qwen3-8B (+10.0%),与 Qwen3-235B 相当。我们相信,DeepSeek-R1-0528 的思维链对于学术界推理模型的研究和工业界针对小模型的开发都将具有重要意义。

DeepSeek-R1-0528-Qwen3-8B 等开源模型的 AIME 2024 对比结果

其他能力更新

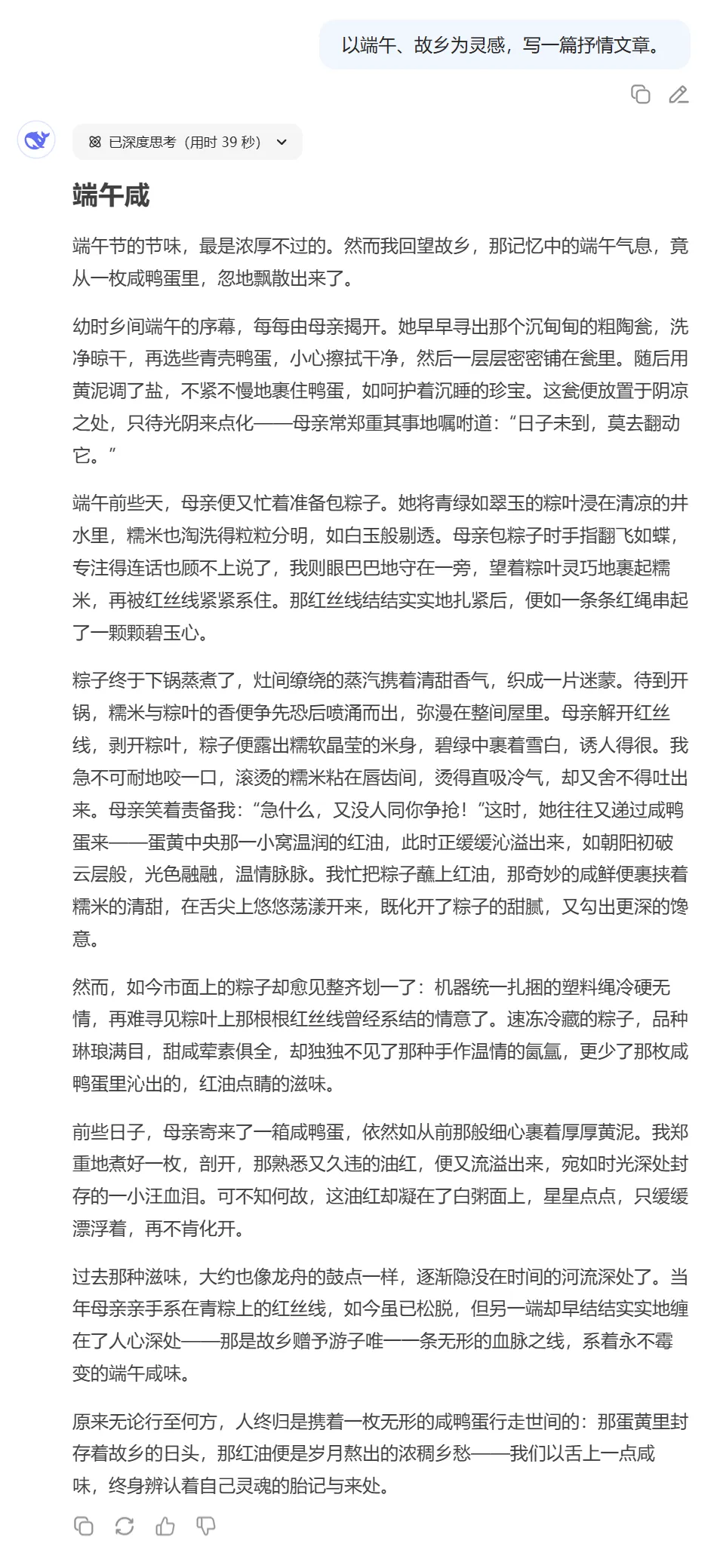

创意写作:在旧版 R1 的基础上,更新后的 R1 模型针对议论文、小说、散文等文体进行了进一步优化,能够输出篇幅更长、结构内容更完整的长篇作品,同时呈现出更加贴近人类偏好的写作风格。

工具调用:DeepSeek-R1-0528 支持工具调用(不支持在 thinking 中进行工具调用)。当前模型 Tau-Bench 测评成绩为 airline 53.5% / retail 63.9%,与 OpenAI o1-high 相当,但与 o3-High 以及 Claude 4 Sonnet 仍有差距。

此外,DeepSeek-R1-0528 在前端代码生成、角色扮演等领域的能力均有更新和提升。

模型开源

与旧版本的 DeepSeek-R1 保持一致,此次我们的开源仓库(包括模型权重)仍然统一采用 MIT License,并允许用户利用模型输出、通过模型蒸馏等方式训练其他模型。